Introdução

Neste texto, segue o registro do processo da série de experimentos intitulada OCEAN DANCE, que apresenta iniciativas de dança desenvolvidas no projeto SPACE-XR. Estes experimentos demonstram a captura de movimentos de dança inseridos no metaverso e convida o participante a interagir com as escalas espaciais sugeridas por Laban, que favorecem uma ampla possibilidade prática para a experimentação do corpo no espaço, a partir de diferentes percursos e dinâmicas. Trata-se de uma investigação que transpõe os movimentos performáticos da dança para o ambiente de um metaverso, o qual, neste caso, é um ambiente virtual tridimensional e multiusuário.

O desenvolvimento destes experimentos começou com sessões de captura de movimento, seguiu para o desenvolvimento visual e para a implementação em realidade virtual (VR) e na análise da experimentação.

Participaram da concepção e desenvolvimento os seguintes pesquisadores: Bernardo Alevato, Fábio Suim, Gabriel Cardoso, Jorge Lopes, Luiz Velho, Orlando Grillo, Sérgio Azevedo, Thaisa Martins e Carolina Navarro, um grupo interdisciplinar com diferentes leituras e perspectivas sobre dança, tecnologia e ambientes imersivos.

O experimento explora como poderia ser a observação de performances de dança em um espaço virtual: um ambiente tridimensional navegável que transponha o movimento captado do físico ao virtual, estimulando reflexões sobre a percepção de presença, a expressão do movimento e as relações entre o virtual e o real. As performances de dança expressam um forte elemento humano, mesmo em imagens geradas por computador. Participaram deste experimento os artistas Thaisa Martins, Helena Bevilaqua e Fabiano Nunes, cujas performances improvisadas formaram a base do estudo. A trilha sonora de duas performances foi criada por Yuri Amorim.

Alguns trabalhos anteriores que inspiraram este experimento incluem: Motion Creation from Mocap Data de Louise Roy no Visgraf [1], o trabalho Notanna de Ana Lívia Cordeiro [2] e Virtual Crossings da Cia. Gilles Jobin.[3] Também é importante mencionar a referência ao trabalho de Rudolf Laban, de maneira seminal, o que aparece nos estudos de parte do grupo, nas capturas e naturalmente na concepção, nas performances dos bailarinos e no cenário, com poliedros regulares como forma de provocar interação em tempo real dentro do ambiente.

O Fluxo do desenvolvimento do projeto envolveu a captura de movimento usando Optitrack [4], o Blender [5] para modelagem e animação e o Unity 3d [6] para implementação através da plataforma Spatial.io [7].

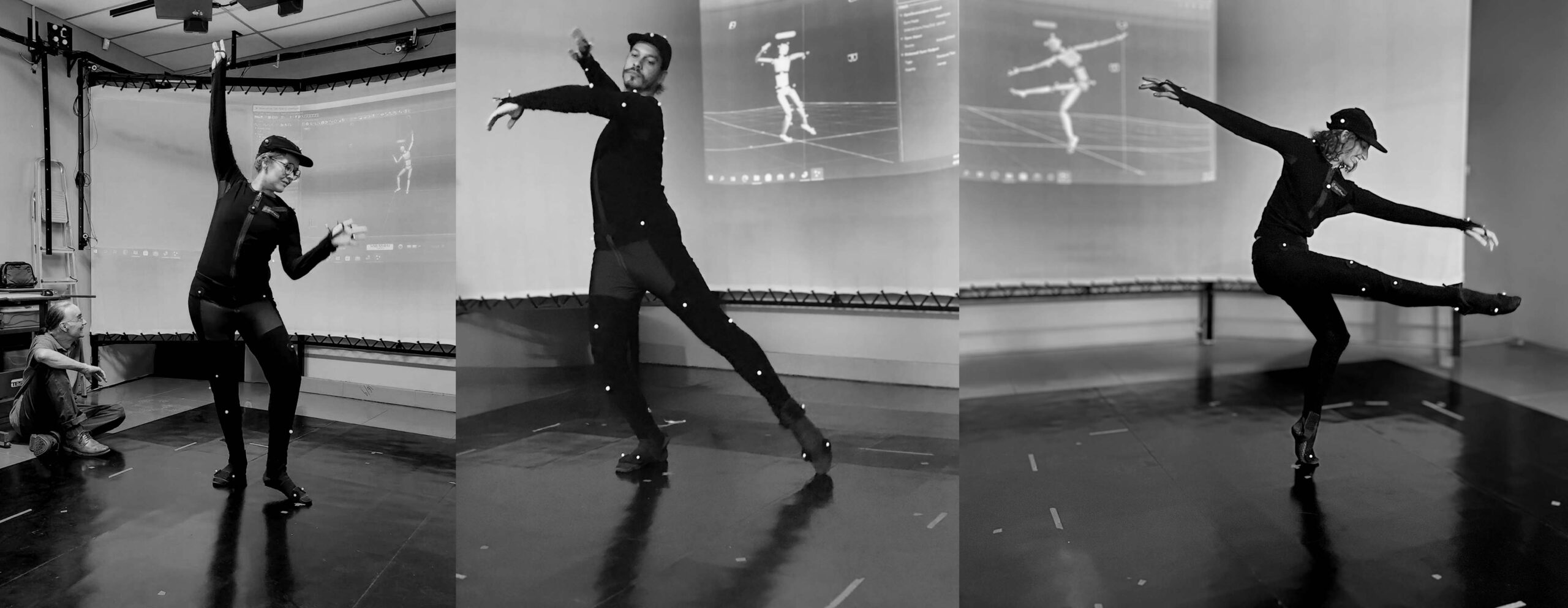

O experimento teve início de forma exploratória, com sessões de captura de movimento no laboratório Visgraf (Vision and Graphics Laboratory/IMPA). A captura de movimento (Motion capture ou MoCap) é uma técnica usada para gravar e analisar os movimentos de um corpo humano ou objeto, com o objetivo de digitalizar esses movimentos e aplicá-los a modelos tridimensionais em animações ou jogos. As coordenadas capturadas são estruturadas de maneira hierárquica com base em esqueletos pré-definidos. Para este fim, foi utilizado o sistema Optitrack, que, por meio de câmeras e sensores reflexivos, é capaz de distinguir os pontos no espaço e capturar através de pontos os movimentos físicos e os convertê-los em dados digitais. Esses dados foram então transmitidos em tempo real para o software Motive, onde parâmetros e a correspondência entre os pontos dos sensores e o modelo virtual são ajustados. O processo gera arquivos BVH, que são reconhecidos pela maioria dos programas de animação 3D.

MoCap (Captura de Movimento)

Após as primeiras sessões de captura com Thaisa Martins, começaram a ser idealizadas possibilidades de implementação em realidade virtual. Em seguida, os bailarinos Helena Bevilaqua e Fabiano Nunes foram convidados para a experimentação, e suas performances foram gravadas em sessões posteriores. De maneira intercalada, foram capturados improvisos e movimentos de escalas de Laban, como cubo e icosaedro.

Concepção Visual

Avatares

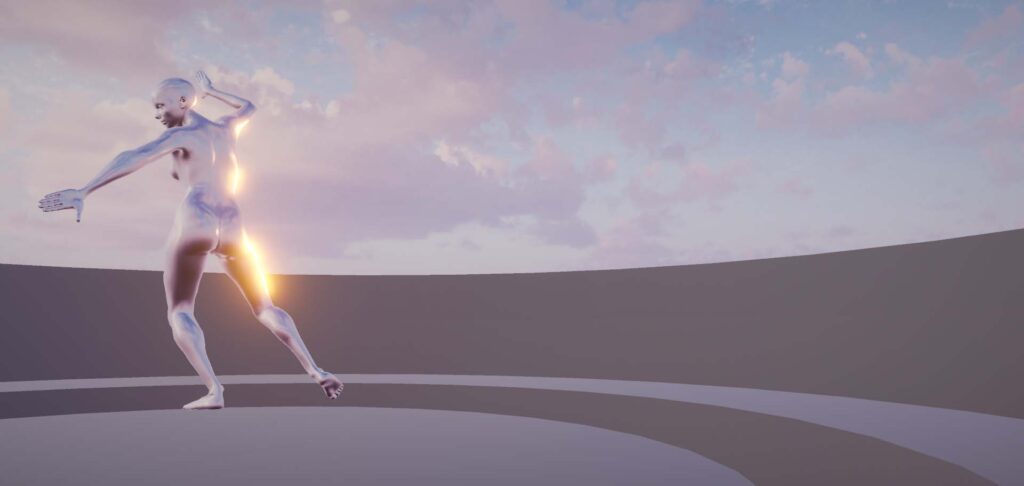

Para criar os modelos virtuais dos dançarinos, foi utilizado o MB-Lab, um complemento (addon) do Blender para a geração de humanoides. Para evitar questões relacionadas ao "vale da estranheza"[5] onde a representação humana mais próxima do real causa uma desagradável percepção de artificialidade, optou-se por um estilo visual minimalista, sem características realistas, mas respeitando as proporções humanas, a fim de representar o movimento de forma fiel. Esse estilo foi influenciado pelo trabalho Virtual Crossings nesse sentido, de buscar uma representação escultural não realista, assim como busca a expressividade do corpo humano nu não sexualizado, conforme conversas do grupo.

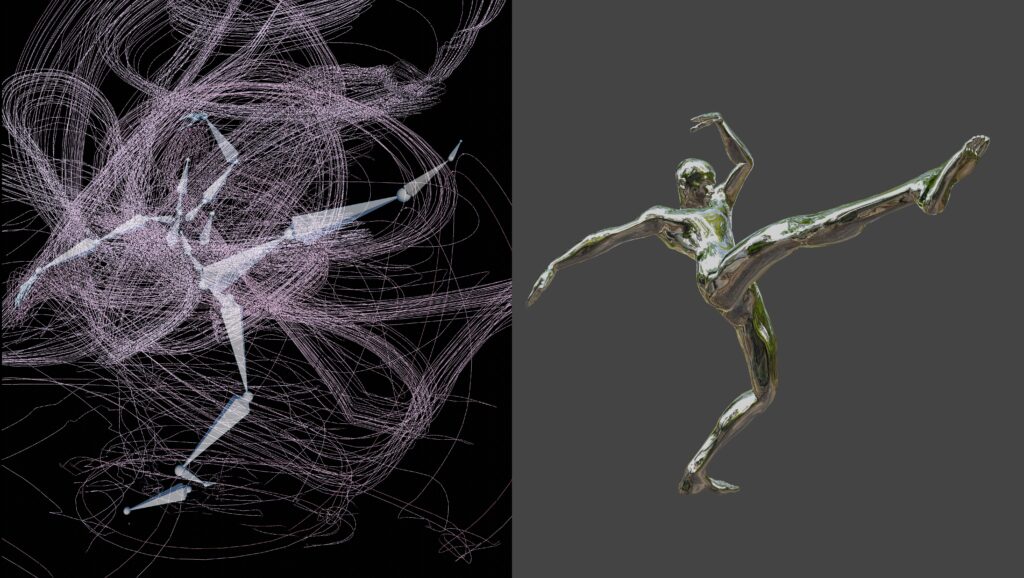

Transferência de Movimento e Correções

A transferência do movimento, contido nos arquivos BVH, foi realizada no Blender. Após a criação do modelo, ele foi estruturado para corresponder à hierarquia de movimentos e à captura dos dados, utilizando um addon do sistema Rokoko para o Blender. Alguns ajustes foram feitos na captura, especialmente com o uso de camadas de movimento no módulo NLA (non-linear animation), que permite a adição de correções sem alterar os quadros-chave registrados.

Ambiente

Um cenário protótipo foi criado no Blender para facilitar a discussão entre a equipe. Esse protótipo permitiu explorar as possibilidades de navegação no espaço virtual, considerando as características da plataforma Spatial e os objetivos do experimento. Inicialmente representado como uma miniatura, o cenário foi gradualmente desenvolvido até se tornar um ambiente interativo, permitindo a navegação dos participantes ao redor da performance em movimento. Além disso, foram colocados poliedros regulares no cenário, sugerindo a relação com as teorias de Rudolf Laban. Rampas foram adicionadas ao ambiente para facilitar a locomoção dos participantes e proporcionar uma navegação mais fluida, oferecendo novos pontos de vista sobre a performance.

Shading

As texturas e a aparência dos modelos e cenários foram inicialmente desenhadas no Blender. No entanto, a aparência final dos materiais reflexivos só foi possível após a implementação no ambiente virtual, quando a interação com o mapa de ambiente e os cenários entrou em jogo. O conceito visual foi inspirado em salas de dança com espelhos e na integração entre o modelo/performer e o ambiente. Por isso, criaram-se materiais que utilizam a reflexão como elemento principal, gerando uma estética específica. A diferença entre o programa de animação e o motor de jogo, neste caso, se tornou um ponto de atenção, pois envolve o processo de concepção e implementação.

Implementação

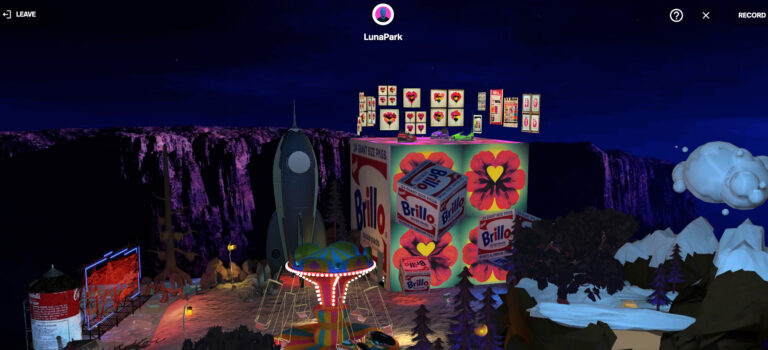

O material foi implementado na plataforma Spatial.io, um ambiente tridimensional que permite interação por meio de navegadores, aplicativos e realidade virtual. Criada com o Unity3D, a plataforma facilita a criação de conteúdo, permitindo a distribuição de arquivos de desenvolvimento para criar experiências imersivas. Por ser um ambiente conectado e multiusuário, o Spatial favorece a interação e visualização coletiva e diálogos entre os participantes. Durante a implementação, optou-se por uma escala ampliada dos modelos, com proporções muito maiores do que as humanas, criando um ponto de vista diferente. A duplicação dos modelos também foi usada em dois ambientes para destacar o aspecto gráfico e simétrico das performances.

O Unity3D é compatível com a importação de esqueletos e animações, especialmente de humanoides, o que permitiu programar interações e adicionar efeitos sonoros e mapas de ambiente ao experimento.

A implementação do experimento teve como foco a simplicidade e a usabilidade, visando um público sem experiência prévia com realidade virtual, garantindo uma interação intuitiva sem a necessidade de instruções complexas. A experiência foi desenvolvida para a visualização tridimensional, alinhada com experiências anteriores de ambientes virtuais criados pelo LAPID (Laboratório de Processamento de Imagens digitais do Museu Nacional/UFRJ), voltados para o patrimônio histórico e cultural.

Experimentação

O material produzido foi exibido durante o seminário DANCE & TECH em duas edições do evento, no Rio de Janeiro e em Porto Alegre. Durante a experimentação, foram observados comportamentos distintos entre os participantes. Alguns, provenientes do campo da dança, tentaram imitar os movimentos da performance e interagiram com os poliedros, enquanto outros simplesmente observaram a apresentação, movendo-se ao redor do modelo virtual em movimento. Também foram feitas observações sobre a transposição do ambiente e a experiência visual do movimento.

Desdobramento em peças de Comunicação Visual

As capturas de movimento também foram utilizadas para o desenvolvimento do material de divulgação do evento DANCE & TECH. A identidade visual do evento foi criada coletivamente pela equipe, e um modelo tridimensional foi gerado a partir de dados de captura de movimento, utilizando tipografia com o nome do evento como mapa de textura.

Considerações

O uso de MoCap proporciona novas possibilidades de expressão corporal em ambientes de realidade expandida. A partir da experiência, surgiram reflexões sobre a sincronicidade e a assincronicidade no uso da captura de movimento, o que pode alterar a percepção de presença no ambiente virtual. É possível vislumbrar uma disseminação maior da utilização de mocap visto que surgem novas ferramentas e técnicas de captura de movimento baseadas em vídeo, mais baratas (e menos precisas) que a utilização de sensores, como MOVE.AI e QuickMagick, tornando esse recurso mais acessível.

O movimento no espaço virtual, visto através do Headset, oferece uma experiência diferente dos outros veículos audiovisuais, pois durante a observação podem ser percebidas nuances e espacialidade, possivelmente enfatizadas pela percepção tridimensional, onde o espectador pode se aproximar ou andar em torno do modelo. A sincronicidade pode ser um talvez seja mais importante que o realismo para transmitir presença, embora este.

Essa experiência também abre possibilidades para a criação de filmes de dança em ambientes virtuais, como machinima, uma vez que vídeos das performances foram gerados em tempo real, com variações de pontos de vista e enquadramentos.

Referências

[1] https://www.visgraf.impa.br/Projects/motioncreation/

[2] https://www.analivia.com.br/nota-anna/

[3] https://www.gillesjobin.com/creation/virtual-crossings/

[4] https://www.Optitrack.com

[5] https://www.blender.org

[6] https://www.unity.com

[7] https://www.spatial.io

[8] https://spectrum.ieee.org/the-uncanny-valley